استارتاپ تحت حمایت انویدیا، حافظه اترنت را برای کمک به هوش مصنوعی اختراع کرد

ظرفیت رم معمولاً برای بسیاری از برنامههای هوش مصنوعی یک گلوگاه است، اما افزودن حافظه به سیستمهای میزبان گاهی اوقات امکانپذیر یا پیچیده نیست. به همین دلیل، Enfabrica، یک استارتاپ تحت حمایت انویدیا، سیستم Emfasys خود را اختراع کرده است که میتواند ترابایتها حافظه DDR5 را با استفاده از اتصال اترنت به هر سروری اضافه کند. این مجموعه حافظه مبتنی بر اترنت برای بارهای کاری استنتاج در مقیاس بزرگ طراحی شده و در حال حاضر با مشتریان منتخب در حال آزمایش است.

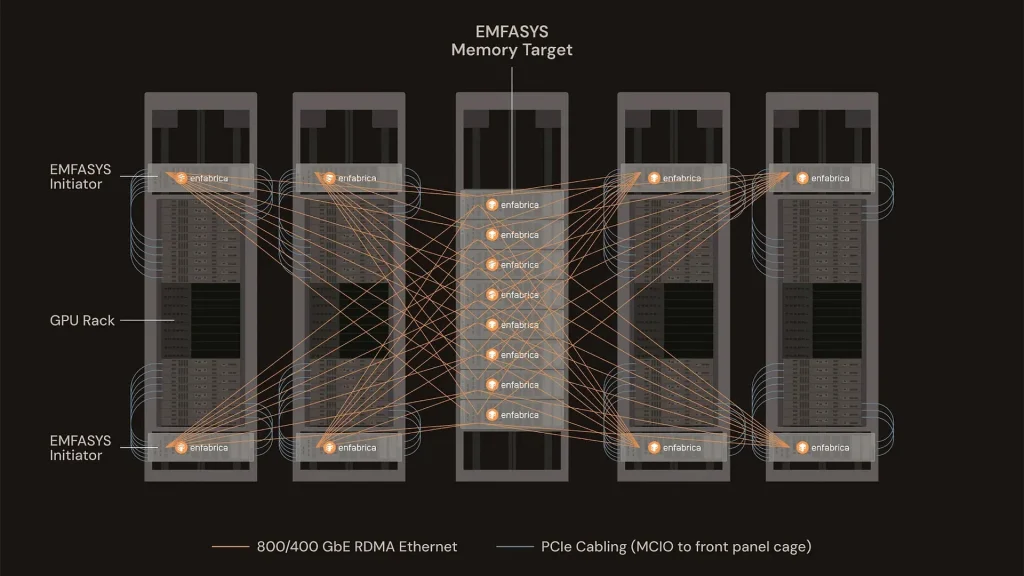

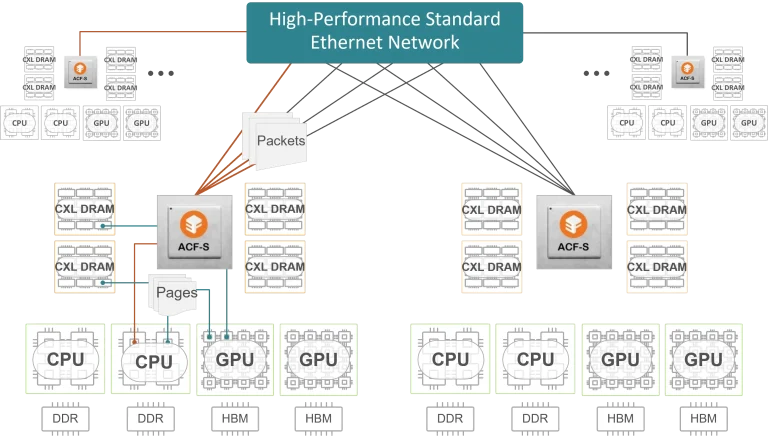

سیستم Emfasys شرکت Enfabrica یک سیستم سازگار با رک است که بر پایه SuperNIC ACF-S این شرکت با توان عملیاتی ۳.۲ ترابیت بر ثانیه (۴۰۰ گیگابایت بر ثانیه) ساخته شده است. این سیستم تا ۱۸ ترابایت حافظه DDR5 را با CXL در بالای آن متصل میکند. مجموعه حافظه میتواند توسط سرورهای GPU چهار و هشت مسیره از طریق پورتهای استاندارد ۴۰۰G یا ۸۰۰G اترنت با استفاده از دسترسی مستقیم از راه دور به حافظه (RDMA) از طریق اترنت قابل دسترسی باشد، بنابراین افزودن یک سیستم Emfasys به تقریباً هر سرور هوش مصنوعی بدون مشکل است.

انتقال داده بین سرورهای GPU و مجموعه حافظه Emfasys با استفاده از RDMA انجام میشود که امکان دسترسی به حافظه با تأخیر کم (اندازهگیری شده در میکروثانیه) و بدون کپی را بدون دخالت CPU با استفاده از پروتکل CXL.mem فراهم میکند. البته، برای دسترسی به مجموعه حافظه Emfasys، سرورها به نرمافزار طبقهبندی حافظه (که تأخیرهای انتقال را پوشش میدهد) نیاز دارند که توسط Enfabrica ارائه یا فعال میشود. این نرمافزار بر روی سختافزار و محیطهای سیستمعامل موجود اجرا میشود و بر پایه رابطهای RDMA که به طور گسترده پذیرفته شدهاند، ساخته شده است، بنابراین استقرار این مجموعه نسبتاً آسان است و نیازی به تغییرات معماری عمده ندارد.

Emfasys شرکت Enfabrica برای رفع نیازهای رو به رشد حافظه در موارد استفاده مدرن هوش مصنوعی طراحی شده است که از پرامپتهای طولانیتر، پنجرههای متنی بزرگ یا عوامل متعدد استفاده میکنند. این بارهای کاری فشار قابل توجهی بر HBM متصل به GPU وارد میکنند که هم محدود و هم گران است. با استفاده از یک مجموعه حافظه خارجی، اپراتورهای مراکز داده میتوانند به طور انعطافپذیری حافظه یک سرور هوش مصنوعی را گسترش دهند، که برای سناریوهای ذکر شده منطقی است.

با استفاده از مجموعه حافظه Emfasys، صاحبان سرورهای هوش مصنوعی کارایی را بهبود میبخشند زیرا منابع محاسباتی بهتر مورد استفاده قرار میگیرند، حافظه گرانقیمت GPU هدر نمیرود و هزینههای کلی زیرساخت کاهش مییابد. طبق گفته Enfabrica، این تنظیمات میتواند هزینه هر توکن تولید شده توسط هوش مصنوعی را تا ۵۰٪ در سناریوهای با گردش بالا و متن طولانی کاهش دهد. وظایف تولید توکن نیز میتوانند به طور یکنواختتری بین سرورها توزیع شوند که گلوگاهها را از بین میبرد.

“AI inference has a memory bandwidth-scaling problem and a memory margin-stacking problem,” said Rochan Sankar, CEO of Enfabrica. “As inference gets more agentic versus conversational, more retentive versus forgetful, the current ways of scaling memory access won’t hold. We built Emfasys to create an elastic, rack-scale AI memory fabric and solve these challenges in a way that has not been done before. Customers are excited to partner with us to build a far more scalable memory movement architecture for their GenAI workloads and drive even better token economics.”

سیستم ساختار حافظه هوش مصنوعی Emfasys و تراشه SuperNIC ACF با سرعت ۳.۲ ترابیت بر ثانیه در حال حاضر توسط مشتریان منتخب در حال ارزیابی و آزمایش هستند. مشخص نیست که عرضه عمومی چه زمانی برنامهریزی شده است، اگر اصلاً برنامهریزی شده باشد.

Enfabrica به طور فعال به عنوان عضو مشاور کنسرسیوم Ultra Ethernet (UEC) فعالیت میکند و به کنسرسیوم Ultra Accelerator Link (UALink) کمک میکند، که نشاندهنده مسیر آینده این شرکت است.

- کولبات

- مرداد 10, 1404

- 29 بازدید