بنچمارک هوش مصنوعی MLPerf Client 1.0 منتشر شد

انقلاب هوش مصنوعی فرا رسیده است، اما برخلاف تغییرات گذشته در محاسبات، اکثر ما با پیشرفتهترین نسخههای مدلهای هوش مصنوعی در فضای ابری تعامل داریم. سرویسهای پیشرو مانند ChatGPT، Claude و Gemini همگی مبتنی بر ابر باقی ماندهاند. با این حال، به دلایلی از جمله حریم خصوصی، تحقیق و کنترل، مدلهای هوش مصنوعی که به صورت محلی اجرا میشوند همچنان مورد توجه هستند و مهم است که بتوان عملکرد هوش مصنوعی سیستمهای کلاینت مجهز به GPU و NPU را به طور قابل اعتماد و بیطرفانه اندازهگیری کرد.

هوش مصنوعی کلاینت همچنان یک فضای بسیار پویا است، زیرا فروشندگان سختافزار و نرمافزار در تلاشند تا انواع بارهای کاری مناسب برای اجرای محلی و بهترین منابع محاسباتی برای اجرای آنها را تعریف کنند. برای کمک به پیمایش در این محیط به سرعت در حال تغییر، کنسرسیوم MLCommons و گروه کاری MLPerf Client آن، یک بنچمارک کلاینت را نگهداری میکنند که با همکاری فروشندگان اصلی سختافزار و نرمافزار توسعه یافته است.

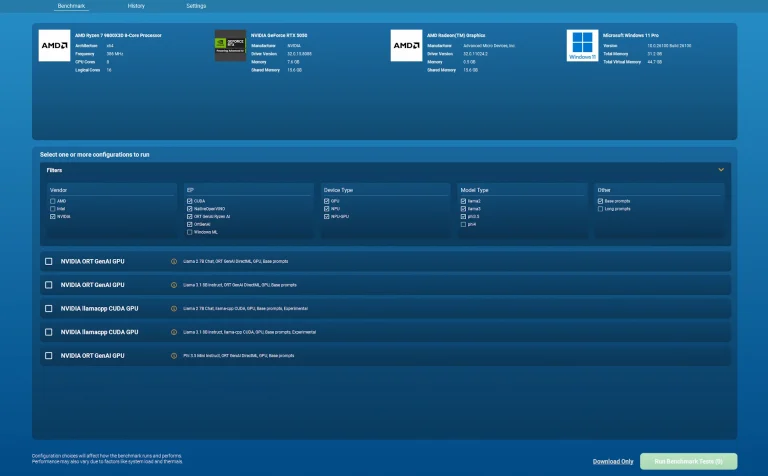

MLPerf Client 1.0 به تازگی با بهبودهای بزرگی نسبت به نسخه قبلی 0.6 منتشر شده است. این ابزار جدید شامل مدلهای هوش مصنوعی بیشتری است، از شتابدهی سختافزاری در دستگاههای بیشتری از فروشندگان بیشتر پشتیبانی میکند و طیف وسیعتری از تعاملات کاربری ممکن با مدلهای زبان بزرگ را آزمایش میکند. همچنین دارای یک رابط کاربری گرافیکی کاربرپسند است که باید جذابیت این تست را برای کاربران عادیتر افزایش دهد.

MLPerf Client 1.0 اکنون میتواند عملکرد را با مدلهای Llama 2 7B Chat و Llama 3.1 8B Instruct از متا، و همچنین Phi 3.5 Mini Instruct از مایکروسافت آزمایش کند. همچنین از مدل آزمایشی Phi 4 Reasoning 14B به عنوان نمونهای احتمالی از عملکرد با یک مدل زبان نسل بعدی با مجموعه پارامترهای بزرگتر و قابلیتهای بیشتر از قبل پشتیبانی میکند.

MLPerf Client 1.0 همچنین عملکرد را در طیف وسیعتری از انواع پرامپتها بررسی میکند. اکنون عملکرد را برای تحلیل کد، همانطور که توسعهدهندگان ممکن است امروزه معمولاً درخواست کنند، بررسی میکند. همچنین میتواند عملکرد خلاصهسازی محتوا را با پنجرههای متنی بزرگ 4000 یا 8000 توکن به عنوان یک ویژگی آزمایشی اندازهگیری کند.

این طیف از مدلها و اندازههای متن، به تستکنندگان سختافزار مانند خود من، مجموعهای از بارهای کاری با مقیاسپذیری گستردهتر را در دستگاههای بیشتر ارائه میدهد. به عنوان مثال، برخی از بارهای کاری آزمایشی در این نسخه برای اجرا به یک GPU با 16 گیگابایت VRAM نیاز دارند، بنابراین میتوانیم سختافزارهای رده بالا را تحت فشار قرار دهیم، نه فقط گرافیکهای یکپارچه و NPUها را.

پشتههای سختافزاری و نرمافزاری هوش مصنوعی کلاینت پویا هستند و روشهای مختلفی که میتوان بارهای کاری هوش مصنوعی را به صورت محلی شتاب داد، صراحتاً گیجکننده است. MLPerf Client 1.0 مسیرهای شتابدهی بیشتری را در سختافزارهای بیشتری نسبت به قبل پوشش میدهد، به ویژه برای دستگاههای کوالکام و اپل. در اینجا لیستی از مسیرهای پشتیبانی شده آمده است:

- پشتیبانی هیبریدی AMD NPU و GPU از طریق ONNX Runtime GenAI و Ryzen AI SDK

- پشتیبانی AMD، Intel و NVIDIA GPU از طریق ONNX Runtime GenAI-DirectML

- پشتیبانی Intel NPU و GPU از طریق OpenVINO

- پشتیبانی هیبریدی Qualcomm Technologies NPU و CPU از طریق Qualcomm Genie و QAIRT SDK

- پشتیبانی Apple Mac GPU از طریق MLX

نسخه 1.0 این بنچمارک همچنین از مسیرهای اجرای سختافزاری آزمایشی زیر پشتیبانی میکند:

- پشتیبانی Intel NPU و GPU از طریق Microsoft Windows ML و OpenVINO execution provider

- پشتیبانی NVIDIA GPU از طریق Llama.cpp-CUDA

- پشتیبانی Apple Mac GPU از طریق Llama.cpp-Metal

آخرین اما نه کماهمیتترین، MLPerf Client 1.0 اکنون دارای یک رابط کاربری گرافیکی در دسترس است که به کاربران امکان میدهد طیف کاملی از بنچمارکها را که میتوانند روی سختافزار خود اجرا کنند، درک کرده و به راحتی از بین آنها انتخاب کنند.

نسخه GUI همچنین نظارت بلادرنگ بر منابع سختافزاری مختلف یک سیستم را فراهم میکند تا بتوانید در یک نگاه ببینید که آیا مسیر اجرای انتخابی شما GPU یا NPU مورد انتظار را به کار میگیرد یا خیر.

نسخههای قبلی MLPerf Client فقط ابزارهای خط فرمان بودند، بنابراین این رابط کاربری جدید باید جذابیت بنچمارک را هم برای کاربران عادی که فقط میخواهند هوش مصنوعی را روی GPU یا NPU (یا هر دو) خود امتحان کنند و هم برای تستکنندگان حرفهای سختافزار که نیاز به جمعآوری و مقایسه نتایج در پیکربندیهای مختلف سختافزاری و نرمافزاری دارند، افزایش دهد.

MLPerf Client 1.0 اکنون به صورت دانلود رایگان برای همه از GitHub در دسترس است. اگر علاقهمند به درک عملکرد سیستم خود در طیف وسیعی از بارهای کاری هوش مصنوعی هستید، آن را امتحان کنید. ما قبلاً مدتی را با نسخه 1.0 گذراندهایم و مشتاقیم که با بررسی عملکرد هوش مصنوعی در طیف وسیعی از سختافزارها، به کاوش در آن ادامه دهیم.

- کولبات

- مرداد 10, 1404

- 28 بازدید