شخصیت برجسته سیلیکون چین از کشور میخواهد استفاده از پردازندههای گرافیکی انویدیا برای هوش مصنوعی را متوقف کند

وی شائوجون، نایب رئیس انجمن صنعت نیمهرسانای چین و مشاور ارشد آکادمیک و دولتی این کشور، از چین و سایر کشورهای آسیایی خواسته است تا استفاده از پردازندههای گرافیکی انویدیا (Nvidia GPUs) برای آموزش و استنتاج هوش مصنوعی را کنار بگذارند. به گزارش بلومبرگ، او در یک همایش در سنگاپور هشدار داد که اتکا به سختافزارهای با منشأ آمریکایی خطرات بلندمدتی برای چین و همتایان منطقهای آن به همراه دارد.

وی از مدل کنونی توسعه هوش مصنوعی در سراسر آسیا انتقاد کرد، مدلی که به شدت از مسیر آمریکایی استفاده از پردازندههای گرافیکی محاسباتی انویدیا یا AMD برای آموزش مدلهای زبان بزرگ مانند ChatGPT و DeepSeek تقلید میکند. او استدلال کرد که این تقلید، استقلال منطقهای را محدود میکند و در صورت عدم رسیدگی میتواند «مرگبار» شود. به گفته وی، استراتژی آسیا باید از الگوی ایالات متحده فاصله بگیرد، به ویژه در زمینههای بنیادی مانند طراحی الگوریتم و زیرساختهای محاسباتی.

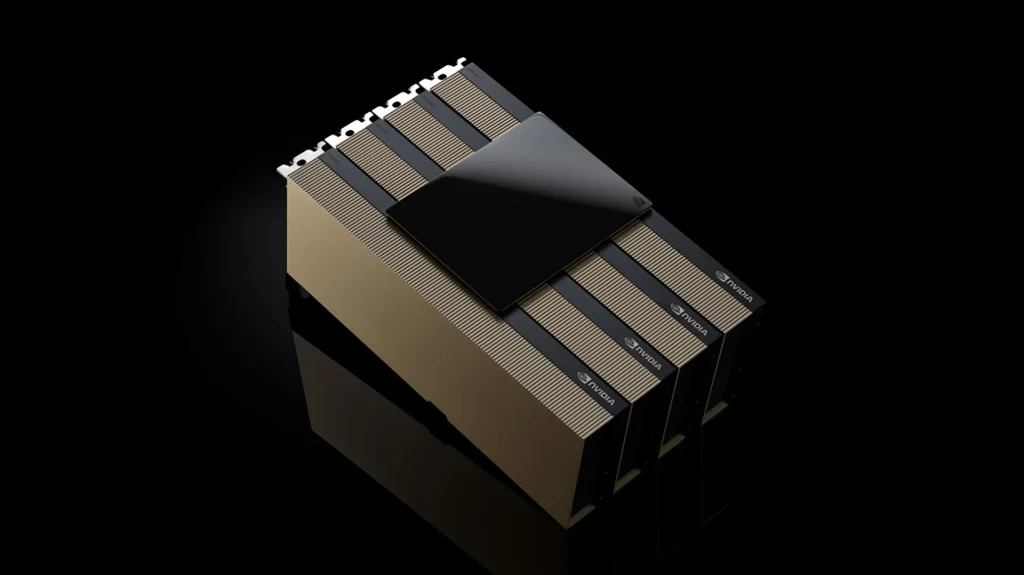

پس از اینکه دولت ایالات متحده در سال ۲۰۲۳ محدودیتهایی را بر عملکرد پردازندههای هوش مصنوعی و HPC که میتوانستند به چین ارسال شوند، اعمال کرد، این امر تنگناهای سختافزاری قابل توجهی در جمهوری خلق چین ایجاد کرد که روند آموزش مدلهای پیشرفته هوش مصنوعی را کند کرد. با وجود این چالشها، وی به نمونههایی مانند ظهور DeepSeek اشاره کرد و آن را دلیلی بر توانایی شرکتهای چینی در دستیابی به پیشرفتهای الگوریتمی قابل توجه حتی بدون سختافزار پیشرفته دانست.

او همچنین به موضع پکن در برابر استفاده از تراشه H20 انویدیا به عنوان نشانهای از تلاش این کشور برای استقلال واقعی در زیرساختهای هوش مصنوعی اشاره کرد. در عین حال، او اذعان داشت که در حالی که صنعت نیمهرسانای چین پیشرفتهایی داشته است، اما هنوز سالها از آمریکا و تایوان عقبتر است، بنابراین احتمال اینکه شرکتهای چینی بتوانند شتابدهندههای هوش مصنوعی با عملکردی قابل مقایسه با محصولات رده بالای انویدیا بسازند، کم است.

وی پیشنهاد کرد که چین باید کلاس جدیدی از پردازندهها را توسعه دهد که به طور خاص برای آموزش مدلهای زبان بزرگ طراحی شدهاند، به جای اینکه به معماریهای پردازندههای گرافیکی (GPU) که در اصل برای پردازش گرافیک طراحی شده بودند، ادامه دهد. اگرچه او طرحی مشخص ارائه نکرد، اما اظهاراتش فراخوانی برای نوآوری داخلی در سطح سیلیکون برای حمایت از جاهطلبیهای هوش مصنوعی چین است. با این حال، او اشارهای نکرد که چین چگونه قصد دارد در رقابت تولید نیمهرساناها به تایوان و ایالات متحده برسد.

او با لحنی مطمئن نتیجهگیری کرد و اظهار داشت که چین با وجود سالها کنترل صادرات و فشارهای سیاسی از سوی ایالات متحده، همچنان از بودجه کافی برخوردار است و مصمم به ادامه ساخت اکوسیستم نیمهرسانای خود است. پیام کلی روشن بود: چین باید از دنبالهروی دست بردارد و با توسعه راهحلهای منحصر به فرد متناسب با نیازهای تکنولوژیکی و استراتژیک خود، پیشرو باشد.

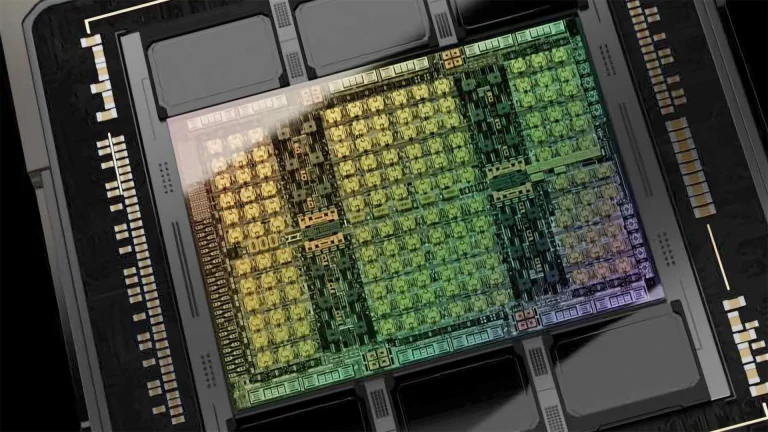

پردازندههای گرافیکی انویدیا در هوش مصنوعی غالب شدند زیرا معماری موازی گسترده آنها برای تسریع عملیات سنگین ماتریسی در یادگیری عمیق ایدهآل بود و کارایی بسیار بیشتری نسبت به CPUها ارائه میداد. همچنین، پشته نرمافزاری CUDA که در سال ۲۰۰۶ معرفی شد، توسعهدهندگان را قادر ساخت تا کدهای عمومی را برای پردازندههای گرافیکی بنویسند و راه را برای استانداردسازی فریمورکهای یادگیری عمیق مانند TensorFlow و PyTorch بر روی سختافزار انویدیا هموار کرد.

با گذشت زمان، انویدیا با سختافزارهای تخصصی (هستههای تنسور، فرمتهای دقت ترکیبی)، یکپارچگی نرمافزاری قوی و پشتیبانی گسترده ابری و OEM، پیشتازی خود را تقویت کرد و پردازندههای گرافیکی خود را به ستون فقرات محاسباتی پیشفرض برای آموزش و استنتاج هوش مصنوعی تبدیل کرد. معماریهای مدرن انویدیا مانند Blackwell برای مراکز داده، بهینهسازیهای فراوانی برای آموزش و استنتاج هوش مصنوعی دارند و تقریباً هیچ ارتباطی با گرافیک ندارند. در مقابل، ASICsهای خاص منظوره — که توسط وی شائوجون حمایت میشوند — هنوز نتوانستهاند برای آموزش یا استنتاج جایگاه خود را پیدا کنند.

- کولبات

- شهریور 20, 1404

- 54 بازدید