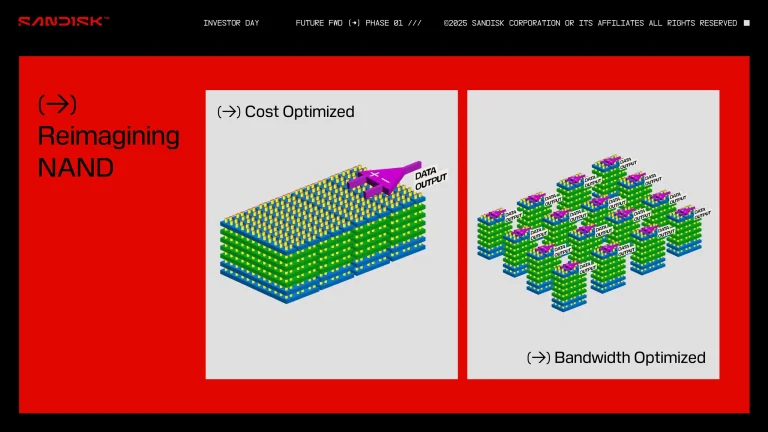

فناوری جدید حافظه سهبعدی پشتهای به دنبال برکناری HBM در استنتاج هوش مصنوعی

استارتاپ حافظه d-Matrix ادعا میکند که حافظه سهبعدی پشتهای آن تا ۱۰ برابر سریعتر و با سرعتهای تا ۱۰ برابر بیشتر از HBM کار خواهد کرد. فناوری محاسبات دیجیتال درون حافظهای سهبعدی (3DIMC) d-Matrix راهحل این شرکت برای نوعی حافظه است که بهطور خاص برای استنتاج هوش مصنوعی (AI inference) ساخته شده است.

حافظه با پهنای باند بالا، یا HBM، به بخش ضروری هوش مصنوعی و محاسبات با عملکرد بالا تبدیل شده است. حافظه HBM ماژولهای حافظه را روی یکدیگر قرار میدهد تا دایهای حافظه را کارآمدتر به هم متصل کرده و به عملکرد حافظه بالاتری دست یابد. با این حال، در حالی که محبوبیت و استفاده از آن همچنان در حال گسترش است، HBM ممکن است بهترین راهحل برای همه وظایف محاسباتی نباشد؛ جایی که برای آموزش هوش مصنوعی کلیدی است، میتواند در استنتاج هوش مصنوعی عملکرد ضعیفتری داشته باشد.

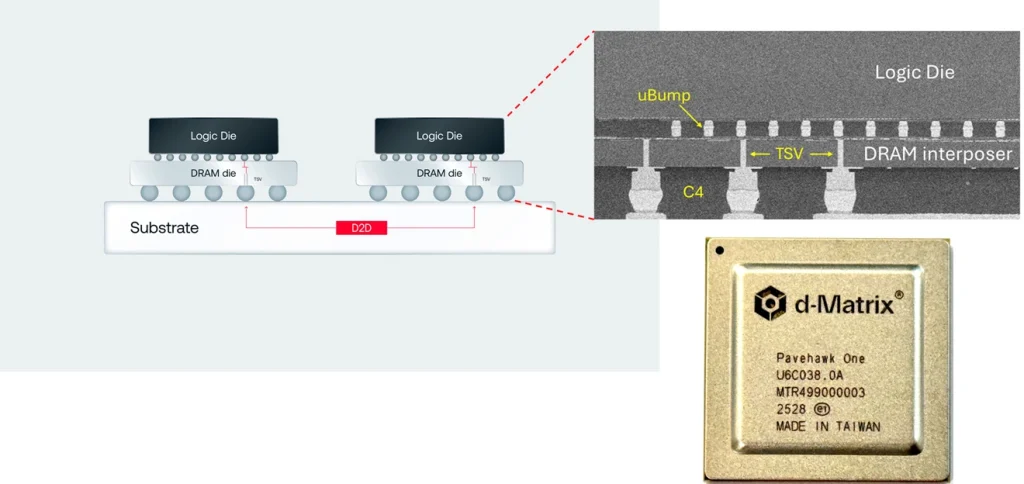

به همین منظور، d-Matrix اخیراً سیلیکون Pavehawk 3DIMC خود را در آزمایشگاه فعال کرده است. سختافزار محاسبات دیجیتال درون حافظهای در حال حاضر شبیه دایهای حافظه LPDDR5 با چیپلتهای DIMC است که روی هم چیده شدهاند و از طریق یک اینترپوزر متصل شدهاند. این پیکربندی به سختافزار DIMC اجازه میدهد تا محاسبات را در خود حافظه انجام دهد. دایهای منطقی DIMC برای ضرب ماتریس-بردار، یک محاسبه رایج که توسط مدلهای هوش مصنوعی مبتنی بر ترانسفورمر در عملیات استفاده میشود، تنظیم شدهاند.

سید شث، بنیانگذار و مدیرعامل d-Matrix، در پست اخیر لینکدین خود گفت: “ما معتقدیم آینده استنتاج هوش مصنوعی نه تنها به بازنگری در محاسبات، بلکه در خود حافظه بستگی دارد.” “استنتاج هوش مصنوعی توسط حافظه محدود شده است، نه فقط FLOPs. مدلها به سرعت در حال رشد هستند و سیستمهای حافظه HBM سنتی بسیار پرهزینه، پرمصرف و با پهنای باند محدود میشوند. 3DIMC بازی را تغییر میدهد. با پشتهسازی حافظه در سه بعد و ادغام تنگاتنگ آن با محاسبات، ما به طور چشمگیری تأخیر را کاهش میدهیم، پهنای باند را بهبود میبخشیم و به بهرهوریهای جدیدی دست مییابیم.”

با فعال بودن Pavehawk در آزمایشگاههای d-Matrix، این شرکت از هماکنون به نسل بعدی خود، Raptor، میاندیشد. در پست وبلاگ شرکت و همچنین اعلامیه لینکدین شث، این شرکت ادعا میکند که این نسل بعدی، که آن نیز بر اساس مدل چیپلت ساخته شده است، HBM را در وظایف استنتاج تا ۱۰ برابر پشت سر خواهد گذاشت و در عین حال ۹۰ درصد انرژی کمتری مصرف خواهد کرد.

پروژه DIMC d-Matrix از الگویی پیروی میکند که در استارتاپهای اخیر و از نظریهپردازان فناوری دیدهایم: این فرض که وظایف محاسباتی خاص، مانند آموزش هوش مصنوعی در مقابل استنتاج، باید سختافزاری داشته باشند که بهطور خاص برای انجام کارآمد همان وظیفه طراحی شده باشد. d-Matrix معتقد است که استنتاج هوش مصنوعی، که اکنون ۵۰ درصد از حجم کاری هوش مصنوعی برخی از هایپراسکیلرها را تشکیل میدهد، وظیفهای به اندازه کافی متفاوت از آموزش است که شایسته نوعی حافظه ساخته شده برای آن باشد.

جایگزینی برای HBM از منظر مالی نیز جذاب است. HBM تنها توسط تعداد انگشتشماری از شرکتهای جهانی، از جمله SK hynix، سامسونگ و میکرون، تولید میشود و قیمتهای آن به هیچ وجه ارزان نیست. SK hynix اخیراً تخمین زده است که بازار HBM تا سال ۲۰۳۰ هر سال ۳۰ درصد رشد خواهد کرد، با افزایش قیمتها برای پاسخگویی به تقاضا. جایگزینی برای این غول ممکن است برای خریداران هوش مصنوعی صرفهجو جذاب باشد — اگرچه حافظهای که منحصراً برای گردش کارها و محاسبات خاص ساخته شده باشد، ممکن است برای مشتریان بالقوه نگران حباب کمی کوتهبینانه به نظر برسد.

- کولبات

- شهریور 13, 1404

- 51 بازدید